Windows 98 Segunda Edición (SE) es una

actualización de Windows 98, fue publicada el 5 de

mayo de 1999. Nació como respueste a un

juicio antimonopolio que perdió Microsoft por hacer

que Internet Explorer fuera parte de Windows

98 (…si lo sé, aún viene este navegador

de serie con los SO de Microsoft…cosas de las leyes y de

tener pasta de sobra como para pagar las multas que se le

impongan…).

Incluye correcciones para muchos problemas menores, un

soporte USB mejorado, y el reemplazo de Internet Explorer

4.0 con el considerablemente más rápido

Internet Explorer 5. También se incluyó la

Conexión Compartida a Internet, además de otras

muchas mejoras que hacían que este fuera un producto mucho

más estable.

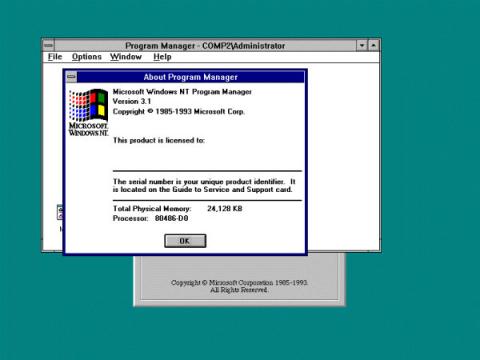

Windows NT

Windows New Technology, más conocido como

Windows NT fue lanzado en Septiembre de 1993. Fue

diseñado para ser un poderoso sistema operativo

multiusuario, basado en lenguaje de alto nivel, independiente del

procesador, con rasgos comparables con Unix.

Su intención fue la de complementar las versiones

de consumidor de las Windows que estaban basadas en el

MS-DOS. NT era la primera versión totalmente en 32 bits de

Windows, mientras que sus colegas orientados al consumidor,

Windows 3.1x y Windows 9x, eran de 16-bit/32-bit híbridos.

Windows 2000, Windows XP, Windows Server 2003, Windows Vista,

Windows Server 2008, Windows Home Server y Windows 7

están basados sobre el sistema de Windows NT,

aunque ellos no estén marcados como Windows

NT.

Windows ME

La edición del Milenio (Milenium Edition)

es una actualización de Windows 98 que toma algunas

características de Windows 2000. Uno de los peores

sistemas operativos desarrollados por Microsoft. Tenía una

lista bastante amplia de incompatibilidades de Hardware que

hacía que dicho sistema operativo no pudiera correr en

todos los equipos.

Personalmente tuve la desgracia de

instalarlo….resultado, dos fallos graves y el disco duro

borrado, con toda la perdida de información que eso

implica

Windows 2000 (Windows NT 5.0)

Windows 2000, (conocido

también como Win2K) sistema operativo de Microsoft

que se puso en circulación el 17 de febrero de 2000 con un

cambio de nomenclatura para su sistema NT. Así, Windows NT

5.0 se pasa a llamar Windows 2000.

Este sistema operativo introdujo algunas

modificaciones respecto a sus predecesores, como el sistema de

archivos NTFS 5, la capacidad de cifrar y comprimir

archivos. Introdujo también las mejoras en el sistema de

componentes COM, introduciendo COM+ que unificó en un solo

paquete de servicios anexados, la tecnología COM y MTS de

Windows NT4, con nuevas ventajas.

Este sistema fue el primer intento de

Microsoft por juntar su versión MS-DOS

(Windows 95, 98, ME) y la NT (3.51, 4) aunque la

fusión definitiva llegaría con Windows

XP.

Esta versión ha tenido mucho

éxito en empresas, que todavía hoy la usan, pero

entre los usuarios de hogares no tuvo mucho

éxito.

Windows XP

Windows XP (cuyo nombre en clave inicial fue

Whistler) y cuyas letras "XP" provienen de la

palabra "eXPeriencia", fue lanzado el 25 de octubre de 2001. Es

uno de los SO más utilizados actualmente, por lo menos a

nivel de los hogares, ya que se estima que en el mundo hay 400

millones de copias de este SO funcionando.

La principal característica de este nuevo Windows

con respecto a Windows 98, es su nueva apariencia. El mayor

cambio en WXP es cosmético, algo que provoca que necesite

mayores requisitos de sistema necesita.

Windows Vista

Y pasamos de un SO querido por muchos usuarios

Windows XP a un SO odiado por casi todo el mundo,

Windows Vista. Durante su desarrollo fue conocido como

Windows Longhorn. Fue lanzado el 30 de noviembre de

2006.

Sus novedades más destacadas son las de agregar

efectos visuales asombrosos y varias opciones innovadoras como

mejor control en las cuentas de usuarios, firewall

bi-direccional, mayor seguridad, anti spyware, Windows Search, la

barra lateral de herramientas, y otras muchas cosas….a

cambio de todo esto conseguirás que muchos de tus

periféricos tengan problemas…que apenas puedas

hacer nada sin que te salgan alertas

constastes…

Windows Home Server

Windows Home Server es un nuevo sistema operativo

para uso doméstico producido por Microsoft. Anunciado el

07 de enero de 2007, en la "Consumer Electronics Show" por Bill

Gates, Windows Home Server intenta ser una solución para

hogares con múltiples PC interconectados en la cual puedan

compartir archivos, hacer copias de seguridad automatizadas, y

acceso remoto. Está basado en Windows Server 2003

SP2.

Windows Server 2008

Windows Server 2008 es el nombre del sistema

operativo para servidores de Microsoft. Es el sucesor de

Windows Server 2003 distribuido al público casi

cinco años antes. Al igual que Windows Vista, Windows

Server 2008 se basa en el núcleo Windows NT

6.0.

Windows 7

El último y más nuevo sistema operativo de

Microsoft es Winfdows 7 o Windows Seven, que

actualmente se encuentra en fase de desarrollo o beta y cuyo

año de salida será el 2010. Se esperan numerosas

mejoras en cuanto a interfaz gráfica, unos mejores tiempos

de arranque y la eliminación o desactivación del

control por parte del usuario (supuestamente no saldrán

tantas alertas de seguridad).

Como aún no ha salido oficialmente no nos

meteremos mucho con él….aunque hay ciertos puntos

que suenan a cachondeo (como el "rumor" de que sólo

podría ejecutar 3 aplicaciones de forma simultanea y que

para ejecutar más abría que pasar por caja…)

.

Buenos esto es todo, si habéis

llegado hasta aquí felicidades, ya conocéis algo

más de la historia de los SO de

Microsoft.

Si os entra la morriña y

deseáis volver a sentir la experiencia de probar alguno

de estos sistemas operativos, os dejo un enlace donde os

podéis casi todos los sistemas operativos de los que os

hemos hablado (pero esto no se lo digáis a nadie

).

La historia de

Internet

Internet surgió de un proyecto desarrollado en

Estados Unidos para apoyar a sus fuerzas militares. Luego de su

creación fue utilizado por el gobierno, universidades y

otros centros académicos.

Internet ha supuesto una revolución sin

precedentes en el mundo de la informática y de las

comunicaciones. Los inventos del telégrafo,

teléfono, radio y ordenador sentaron las bases para esta

integración de capacidades nunca antes vivida. Internet es

a la vez una oportunidad de difusión mundial, un mecanismo

de propagación de la información y un medio de

colaboración e interacción entre los individuos y

sus ordenadores independientemente de su localización

geográfica.

Orígenes de Internet

La primera descripción documentada acerca de las

interacciones sociales que podrían ser propiciadas a

través del networking (trabajo en red)

está contenida en una serie de memorándums escritos

por J.C.R. Licklider, del Massachusetts Institute of Technology,

en Agosto de 1962, en los cuales Licklider discute sobre su

concepto de Galactic Network (Red

Galáctica).

El concibió una red interconectada globalmente a

través de la que cada uno pudiera acceder desde cualquier

lugar a datos y programas. En esencia, el concepto era muy

parecido a la Internet actual. Licklider fue el principal

responsable del programa de investigación en ordenadores

de la DARPA desde Octubre de 1962. Mientras trabajó en

DARPA convenció a sus sucesores Ivan Sutherland, Bob

Taylor, y el investigador del MIT Lawrence G. Roberts de la

importancia del concepto de trabajo en red.

En Julio de 1961 Leonard Kleinrock publicó desde

el MIT el primer documento sobre la teoría de

conmutación de paquetes. Kleinrock convenció a

Roberts de la factibilidad teórica de las comunicaciones

vía paquetes en lugar de circuitos, lo cual resultó

ser un gran avance en el camino hacia el trabajo

informático en red. El otro paso fundamental fue hacer

dialogar a los ordenadores entre sí.

Para explorar este terreno, en 1965, Roberts

conectó un ordenador TX2 en Massachusetts con un Q-32 en

California a través de una línea telefónica

conmutada de baja velocidad, creando así la primera

(aunque reducida) red de ordenadores de área amplia

jamás construida. El resultado del experimento fue la

constatación de que los ordenadores de tiempo compartido

podían trabajar juntos correctamente, ejecutando programas

y recuperando datos a discreción en la máquina

remota, pero que el sistema telefónico de

conmutación de circuitos era totalmente inadecuado para

esta labor. La convicción de Kleinrock acerca de la

necesidad de la conmutación de paquetes quedó pues

confirmada.

A finales de 1966 Roberts se trasladó a la DARPA

a desarrollar el concepto de red de ordenadores y

rápidamente confeccionó su plan para ARPANET,

publicándolo en 1967. En la conferencia en la que

presentó el documento se exponía también un

trabajo sobre el concepto de red de paquetes a cargo de Donald

Davies y Roger Scantlebury del NPL. Scantlebury le habló a

Roberts sobre su trabajo en el NPL así como sobre el de

Paul Baran y otros en RAND. El grupo RAND había escrito un

documento sobre redes de conmutación de paquetes para

comunicación vocal segura en el ámbito militar, en

1964.

Ocurrió que los trabajos del MIT (1961-67), RAND

(1962-65) y NPL (1964-67) habían discurrido en paralelo

sin que los investigadores hubieran conocido el trabajo de los

demás. La palabra packet (paquete) fue adoptada a

partir del trabajo del NPL y la velocidad de la línea

propuesta para ser usada en el diseño de ARPANET fue

aumentada desde 2,4 Kbps hasta 50 Kbps (5).

En Agosto de 1968, después de que Roberts y la

comunidad de la DARPA hubieran refinado la estructura global y

las especificaciones de ARPANET, DARPA lanzó un RFQ para

el desarrollo de uno de sus componentes clave: los conmutadores

de paquetes llamados interface message processors (IMPs,

procesadores de mensajes de interfaz).

El RFQ fue ganado en Diciembre de 1968 por un grupo

encabezado por Frank Heart, de Bolt Beranek y Newman (BBN).

Así como el equipo de BBN trabajó en IMPs con Bob

Kahn tomando un papel principal en el diseño de la

arquitectura de la ARPANET global, la topología de red y

el aspecto económico fueron diseñados y optimizados

por Roberts trabajando con Howard Frank y su equipo en la Network

Analysis Corporation, y el sistema de medida de la red fue

preparado por el equipo de Kleinrock de la Universidad de

California, en Los Angeles (6).

A causa del temprano desarrollo de la teoría de

conmutación de paquetes de Kleinrock y su énfasis

en el análisis, diseño y medición, su

Network Measurement Center (Centro de Medidas de Red) en

la UCLA fue seleccionado para ser el primer nodo de ARPANET. Todo

ello ocurrió en Septiembre de 1969, cuando BBN

instaló el primer IMP en la UCLA y quedó conectado

el primer ordenador host.

El proyecto de Doug Engelbart denominado

Augmentation of Human Intelect (Aumento del Intelecto

Humano) que incluía NLS, un primitivo sistema hipertexto

en el Instituto de Investigación de Standford (SRI)

proporcionó un segundo nodo. El SRI patrocinó el

Network Information Center , liderado por Elizabeth

(Jake) Feinler, que desarrolló funciones tales como

mantener tablas de nombres de host para la

traducción de direcciones así como un directorio de

RFCs ( Request For Comments ).

Un mes más tarde, cuando el SRI fue conectado a

ARPANET, el primer mensaje de host a host fue

enviado desde el laboratorio de Leinrock al SRI. Se

añadieron dos nodos en la Universidad de California, Santa

Bárbara, y en la Universidad de Utah. Estos dos

últimos nodos incorporaron proyectos de

visualización de aplicaciones, con Glen Culler y Burton

Fried en la UCSB investigando métodos para mostrar

funciones matemáticas mediante el uso de "storage

displays" ( N. del T. : mecanismos que incorporan

buffers de monitorización distribuidos en red

para facilitar el refresco de la visualización) para

tratar con el problema de refrescar sobre la red, y Robert Taylor

e Ivan Sutherland en Utah investigando métodos de

representación en 3-D a través de la

red.

Así, a finales de 1969, cuatro ordenadores

host fueron conectados cojuntamente a la ARPANET inicial

y se hizo realidad una embrionaria Internet. Incluso en esta

primitiva etapa, hay que reseñar que la

investigación incorporó tanto el trabajo mediante

la red ya existente como la mejora de la utilización de

dicha red. Esta tradición continúa hasta el

día de hoy.

Se siguieron conectando ordenadores rápidamente a

la ARPANET durante los años siguientes y el trabajo

continuó para completar un protocolo host a

host funcionalmente completo, así como software

adicional de red. En Diciembre de 1970, el Network Working

Group (NWG) liderado por S.Crocker acabó el protocolo

host a host inicial para ARPANET, llamado

Network Control Protocol (NCP, protocolo de control de

red). Cuando en los nodos de ARPANET se completó la

implementación del NCP durante el periodo 1971-72, los

usuarios de la red pudieron finalmente comenzar a desarrollar

aplicaciones.

En Octubre de 1972, Kahn organizó una gran y muy

exitosa demostración de ARPANET en la International

Computer Communication Conference . Esta fue la primera

demostración pública de la nueva tecnología

de red. Fue también en 1972 cuando se introdujo la primera

aplicación "estrella": el correo electrónico.

En Marzo, Ray Tomlinson, de BBN, escribió el software

básico de envío-recepción de mensajes de

correo electrónico, impulsado por la necesidad que

tenían los desarrolladores de ARPANET de un mecanismo

sencillo de coordinación.

En Julio, Roberts expandió su valor

añadido escribiendo el primer programa de utilidad de

correo electrónico para relacionar, leer selectivamente,

almacenar, reenviar y responder a mensajes. Desde entonces, la

aplicación de correo electrónico se

convirtió en la mayor de la red durante más de una

década. Fue precursora del tipo de actividad que

observamos hoy día en la World Wide Web , es

decir, del enorme crecimiento de todas las formas de

tráfico persona a persona.

Conceptos iniciales sobre Internetting

La ARPANET original evolucionó hacia Internet.

Internet se basó en la idea de que habría

múltiples redes independientes, de diseño casi

arbitrario, empezando por ARPANET como la red pionera de

conmutación de paquetes, pero que pronto incluiría

redes de paquetes por satélite, redes de paquetes por

radio y otros tipos de red. Internet como ahora la conocemos

encierra una idea técnica clave, la de arquitectura

abierta de trabajo en red.

Bajo este enfoque, la elección de cualquier

tecnología de red individual no respondería a una

arquitectura específica de red sino que podría ser

seleccionada libremente por un proveedor e interactuar con las

otras redes a través del metanivel de la arquitectura de

Internetworking (trabajo entre redes). Hasta ese

momento, había un sólo método para "federar"

redes.

Era el tradicional método de conmutación

de circuitos, por el cual las redes se interconectaban a nivel de

circuito pasándose bits individuales síncronamente

a lo largo de una porción de circuito que unía un

par de sedes finales. Cabe recordar que Kleinrock había

mostrado en 1961 que la conmutación de paquetes era el

método de conmutación más

eficiente.

Juntamente con la conmutación de paquetes, las

interconexiones de propósito especial entre redes

constituían otra posibilidad. Y aunque había otros

métodos limitados de interconexión de redes

distintas, éstos requerían que una de ellas fuera

usada como componente de la otra en lugar de actuar simplemente

como un extremo de la comunicación para ofrecer servicio

end-to-end (extremo a extremo).

En una red de arquitectura abierta, las redes

individuales pueden ser diseñadas y desarrolladas

separadamente y cada una puede tener su propia y única

interfaz, que puede ofrecer a los usuarios y/u otros proveedores,

incluyendo otros proveedores de Internet. Cada red puede ser

diseñada de acuerdo con su entorno específico y los

requerimientos de los usuarios de aquella red.

No existen generalmente restricciones en los tipos de

red que pueden ser incorporadas ni tampoco en su ámbito

geográfico, aunque ciertas consideraciones

pragmáticas determinan qué posibilidades tienen

sentido. La idea de arquitectura de red abierta fue introducida

primeramente por Kahn un poco antes de su llegada a la DARPA en

1972. Este trabajo fue originalmente parte de su programa de

paquetería por radio, pero más tarde se

convirtió por derecho propio en un programa

separado.

Entonces, el programa fue llamado Internetting

. La clave para realizar el trabajo del sistema de

paquetería por radio fue un protocolo extremo a extremo

seguro que pudiera mantener la comunicación efectiva

frente a los cortes e interferencias de radio y que pudiera

manejar las pérdidas intermitentes como las causadas por

el paso a través de un túnel o el bloqueo a nivel

local. Kahn pensó primero en desarrollar un protocolo

local sólo para la red de paquetería por radio

porque ello le hubiera evitado tratar con la multitud de sistemas

operativos distintos y continuar usando NCP.

Sin embargo, NCP no tenía capacidad para

direccionar redes y máquinas más allá de un

destino IMP en ARPANET y de esta manera se requerían

ciertos cambios en el NCP. La premisa era que ARPANET no

podía ser cambiado en este aspecto. El NCP se basaba en

ARPANET para proporcionar seguridad extremo a extremo. Si alguno

de los paquetes se perdía, el protocolo y presumiblemente

cualquier aplicación soportada sufriría una grave

interrupción. En este modelo, el NCP no tenía

control de errores en el host porque ARPANET

había de ser la única red existente y era tan

fiable que no requería ningún control de errores en

la parte de los host s.

Así, Kahn decidió desarrollar una nueva

versión del protocolo que pudiera satisfacer las

necesidades de un entorno de red de arquitectura abierta. El

protocolo podría eventualmente ser denominado

"Transmisson-Control Protocol/Internet Protocol"

(TCP/IP, protocolo de control de transmisión /protocolo de

Internet). Así como el NCP tendía a actuar como un

driver (manejador) de dispositivo, el nuevo protocolo

sería más bien un protocolo de

comunicaciones.

Ideas a prueba

DARPA formalizó tres contratos con Stanford

(Cerf), BBN (Ray Tomlinson) y UCLA (Peter Kirstein) para

implementar TCP/IP (en el documento original de Cerf y Kahn se

llamaba simplemente TCP pero contenía ambos componentes).

El equipo de Stanford, dirigido por Cerf, produjo las

especificaciones detalladas y al cabo de un año hubo tres

implementaciones independientes de TCP que podían

interoperar.

Este fue el principio de un largo periodo de

experimentación y desarrollo para evolucionar y madurar el

concepto y tecnología de Internet. Partiendo de las tres

primeras redes ARPANET, radio y satélite y de sus

comunidades de investigación iniciales, el entorno

experimental creció hasta incorporar esencialmente

cualquier forma de red y una amplia comunidad de

investigación y desarrollo [REK78]. Cada expansión

afrontó nuevos desafíos.

Las primeras implementaciones de TCP se hicieron para

grandes sistemas en tiempo compartido como Tenex y TOPS 20.

Cuando aparecieron los ordenadores de sobremesa (

desktop ), TCP era demasiado grande y complejo como para

funcionar en ordenadores personales. David Clark y su equipo de

investigación del MIT empezaron a buscar la

implementación de TCP más sencilla y compacta

posible.

La desarrollaron, primero para el Alto de Xerox (la

primera estación de trabajo personal desarrollada en el

PARC de Xerox), y luego para el PC de IBM. Esta

implementación operaba con otras de TCP, pero estaba

adaptada al conjunto de aplicaciones y a las prestaciones de un

ordenador personal, y demostraba que las estaciones de trabajo,

al igual que los grandes sistemas, podían ser parte de

Internet.

En los años 80, el desarrollo de LAN, PC y

estaciones de trabajo permitió que la naciente Internet

floreciera. La tecnología Ethernet, desarrollada por Bob

Metcalfe en el PARC de Xerox en 1973, es la dominante en

Internet, y los PCs y las estaciones de trabajo los modelos de

ordenador dominantes. El cambio que supone pasar de una pocas

redes con un modesto número de hosts (el modelo

original de ARPANET) a tener muchas redes dio lugar a nuevos

conceptos y a cambios en la tecnología.

En primer lugar, hubo que definir tres clases de redes

(A, B y C) para acomodar todas las existentes. La clase A

representa a las redes grandes, a escala nacional (pocas redes

con muchos ordenadores); la clase B representa redes regionales;

por último, la clase C representa redes de área

local (muchas redes con relativamente pocos

ordenadores).

Como resultado del crecimiento de Internet, se produjo

un cambio de gran importancia para la red y su gestión.

Para facilitar el uso de Internet por sus usuarios se asignaron

nombres a los host s de forma que resultara innecesario

recordar sus direcciones numéricas. Originalmente

había un número muy limitado de máquinas,

por lo que bastaba con una simple tabla con todos los ordenadores

y sus direcciones asociadas.

El cambio hacia un gran número de redes

gestionadas independientemente (por ejemplo, las LAN)

significó que no resultara ya fiable tener una

pequeña tabla con todos los host s. Esto

llevó a la invención del DNS ( Domain Name

System , sistema de nombres de dominio) por Paul Mockapetris

de USC/ISI. El DNS permitía un mecanismo escalable y

distribuido para resolver jerárquicamente los nombres de

los host s (por ejemplo, www.acm.org o

www.ati.es ) en direcciones de

Internet.

El incremento del tamaño de Internet

resultó también un desafío para los

routers . Originalmente había un sencillo

algoritmo de enrutamiento que estaba implementado uniformemente

en todos los routers de Internet. A medida que el número

de redes en Internet se multiplicaba, el diseño inicial no

era ya capaz de expandirse, por lo que fue sustituido por un

modelo jerárquico de enrutamiento con un protocolo IGP (

Interior Gateway Protocol , protocolo interno de

pasarela) usado dentro de cada región de Internet y un

protocolo EGP ( Exterior Gateway Protocol , protocolo

externo de pasarela) usado para mantener unidas las

regiones.

El diseño permitía que distintas regiones

utilizaran IGP distintos, por lo que los requisitos de coste,

velocidad de configuración, robustez y escalabilidad,

podían ajustarse a cada situación. Los algoritmos

de enrutamiento no eran los únicos en poner en

dificultades la capacidad de los routers ,

también lo hacía el tamaño de la tablas de

direccionamiento. Se presentaron nuevas aproximaciones a la

agregación de direcciones (en particular CIDR,

Classless Interdomain Routing , enrutamiento entre

dominios sin clase) para controlar el tamaño de las tablas

de enrutamiento.

A medida que evolucionaba Internet, la

propagación de los cambios en el software, especialmente

el de los host s, se fue convirtiendo en uno de sus

mayores desafíos. DARPA financió a la Universidad

de California en Berkeley en una investigación sobre

modificaciones en el sistema operativo Unix, incorporando el

TCP/IP desarrollado en BBN. Aunque posteriormente Berkeley

modificó esta implementación del BBN para que

operara de forma más eficiente con el sistema y el kernel

de Unix, la incorporación de TCP/IP en el sistema Unix BSD

demostró ser un elemento crítico en la

difusión de los protocolos entre la comunidad

investigadora.

BSD empezó a ser utilizado en sus operaciones

diarias por buena parte de la comunidad investigadora en temas

relacionados con informática. Visto en perspectiva, la

estrategia de incorporar los protocolos de Internet en un sistema

operativo utilizado por la comunidad investigadora fue uno de los

elementos clave en la exitosa y amplia aceptación de

Internet.

Uno de los desafíos más interesantes fue

la transición del protocolo para host s de

ARPANET desde NCP a TCP/IP el 1 de enero de 1983. Se trataba de

una ocasión muy importante que exigía que todos los

host s se convirtieran simultáneamente o que

permanecieran comunicados mediante mecanismos desarrollados para

la ocasión.

La transición fue cuidadosamente planificada

dentro de la comunidad con varios años de

antelación a la fecha, pero fue sorprendentemente sobre

ruedas (a pesar de dar la lugar a la distribución de

insignias con la inscripción "Yo sobreviví a la

transición a TCP/IP").

TCP/IP había sido adoptado como un

estándar por el ejército norteamericano tres

años antes, en 1980. Esto permitió al

ejército empezar a compartir la tecnología DARPA

basada en Internet y llevó a la separación final

entre las comunidades militares y no militares. En 1983 ARPANET

estaba siendo usada por un número significativo de

organizaciones operativas y de investigación y desarrollo

en el área de la defensa. La transición desde NCP a

TCP/IP en ARPANET permitió la división en una

MILNET para dar soporte a requisitos operativos y una ARPANET

para las necesidades de investigación.

Así, en 1985, Internet estaba firmemente

establecida como una tecnología que ayudaba a una amplia

comunidad de investigadores y desarrolladores, y empezaba a ser

empleada por otros grupos en sus comunicaciones diarias entre

ordenadores. El correo electrónico se empleaba ampliamente

entre varias comunidades, a menudo entre distintos sistemas. La

interconexión entre los diversos sistemas de correo

demostraba la utilidad de las comunicaciones electrónicas

entre personas.

La

transición hacia una infraestructura

global

Al mismo tiempo que la tecnología Internet estaba

siendo validada experimentalmente y usada ampliamente entre un

grupo de investigadores de informática se estaban

desarrollando otras redes y tecnologías. La utilidad de

las redes de ordenadores (especialmente el correo

electrónico utilizado por los contratistas de DARPA y el

Departamento de Defensa en ARPANET) siguió siendo evidente

para otras comunidades y disciplinas de forma que a mediados de

los años 70 las redes de ordenadores comenzaron a

difundirse allá donde se podía encontrar

financiación para las mismas.

El Departamento norteamericano de Energía (DoE,

Deparment of Energy ) estableció MFENet para sus

investigadores que trabajaban sobre energía de

fusión, mientras que los físicos de altas

energías fueron los encargados de construir HEPNet. Los

físicos de la NASA continuaron con SPAN y Rick Adrion,

David Farber y Larry Landweber fundaron CSNET para la comunidad

informática académica y de la industria con la

financiación inicial de la NFS ( National Science

Foundation , Fundación Nacional de la Ciencia) de

Estados Unidos.

La libre diseminación del sistema operativo Unix

de ATT dio lugar a USENET, basada en los protocolos de

comunicación UUCP de Unix, y en 1981 Greydon Freeman e Ira

Fuchs diseñaron BITNET, que unía los ordenadores

centrales del mundo académico siguiendo el paradigma de

correo electrónico como "postales". Con la

excepción de BITNET y USENET, todas las primeras redes

(como ARPANET) se construyeron para un propósito

determinado.

Es decir, estaban dedicadas (y restringidas) a

comunidades cerradas de estudiosos; de ahí las escasas

presiones por hacer estas redes compatibles y, en consecuencia,

el hecho de que durante mucho tiempo no lo fueran. Además,

estaban empezando a proponerse tecnologías alternativas en

el sector comercial, como XNS de Xerox, DECNet, y la SNA de IBM

(8).

Sólo restaba que los programas ingleses JANET

(1984) y norteamericano NSFNET (1985) anunciaran

explícitamente que su propósito era servir a toda

la comunidad de la enseñanza superior sin importar su

disciplina. De hecho, una de las condiciones para que una

universidad norteamericana recibiera financiación de la

NSF para conectarse a Internet era que "la conexión

estuviera disponible para todos los usuarios

cualificados del campus".

En 1985 Dennins Jenning acudió desde Irlanda para

pasar un año en NFS dirigiendo el programa NSFNET.

Trabajó con el resto de la comunidad para ayudar a la NSF

a tomar una decisión crítica: si TCP/IP

debería ser obligatorio en el programa NSFNET. Cuando

Steve Wolff llegó al programa NFSNET en 1986

reconoció la necesidad de una infraestructura de red

amplia que pudiera ser de ayuda a la comunidad investigadora y a

la académica en general, junto a la necesidad de

desarrollar una estrategia para establecer esta infraestructura

sobre bases independientes de la financiación

pública directa. Se adoptaron varias políticas y

estrategias para alcanzar estos fines.

La NSF optó también por mantener la

infraestructura organizativa de Internet existente (DARPA)

dispuesta jerárquicamente bajo el IAB ( Internet

Activities Board , Comité de Actividades de

Internet). La declaración pública de esta

decisión firmada por todos sus autores (por los grupos de

Arquitectura e Ingeniería de la IAB, y por el NTAG de la

NSF) apareció como la RFC 985 ("Requisitos para pasarelas

de Internet") que formalmente aseguraba la interoperatividad

entre las partes de Internet dependientes de DARPA y de

NSF.

El backbone había hecho la

transición desde una red construida con routers

de la comunidad investigadora (los routers Fuzzball de

David Mills) a equipos comerciales. En su vida de ocho

años y medio, el backbone había crecido

desde seis nodos con enlaces de 56Kb a 21 nodos con enlaces

múltiples de 45Mb.Había visto crecer Internet hasta

alcanzar más de 50.000 redes en los cinco continentes y en

el espacio exterior, con aproximadamente 29.000 redes en los

Estados Unidos.

El efecto del ecumenismo del programa NSFNET y su

financiación (200 millones de dólares entre 1986 y

1995) y de la calidad de los protocolos fue tal que en 1990,

cuando la propia ARPANET se disolvió, TCP/IP había

sustituido o marginado a la mayor parte de los restantes

protocolos de grandes redes de ordenadores e IP estaba en camino

de convertirse en el servicio portador de la llamada

Infraestructura Global de Información.

El futuro:

Internet 2

Internet2 es el futuro de la red de redes y está

formado actualmente por un consorcio dirigido por 206

universidades que junto a la industria de comunicaciones y el

gobierno están desarrollando nuevas técnicas de

conexión que acelerarán la capacidad de

transferencia entre servidores.

Sus objetivos están enfocados a la

educación y la investigación académica.

Además buscan aprovechar aplicaciones de audio y video que

demandan más capacidad de transferencia de ancho de

banda

Blas Pascal (1623-1662). El honor de

ser considerado como el "padre" de la computadora

le correspondió al ilustre filósofo y

científico francés quien siglo y medio

después de Leonardo da Vinci inventó y

construyó la primera máquina calculadora

automática utilizable, precursora de las modernas

computadoras. Entre otras muchas cosas, Pascal desarrolló

la teoría de las probabilidades, piedra angular de las

matemáticas modernas. La pascalina funciona en base al

mismo principio del odómetro (cuenta kilómetros) de

los automóviles, que dicho sea de paso, es el mismo

principio en que se basan las calculadoras mecánicas

antecesoras de las electrónicas, utilizadas no hace tanto

tiempo. En un juego de ruedas, en las que cada una contiene los

dígitos, cada vez que una rueda completa una vuelta, la

rueda siguiente avanza un décimo de

vuelta.

A pesar de que Pascal fue enaltecido por

toda Europa debido a sus logros, la Pascalina, resultó un

desconsolador fallo financiero, pues para esos momentos,

resultaba más costosa que la labor humana para los

cálculos aritméticos.

Atanasoff Y Berry Una antigua

patente de un dispositivo que mucha gente creyó que era la

primera computadora digital electrónica, se

invalidó en 1973 por orden de un tribunal federal, y

oficialmente se le dio el crédito a John V. Atanasoff como

el inventor de la computadora digital

electrónica. El Dr. Atanasoff, catedrático de

la Universidad Estatal de Iowa, desarrolló la primera

computadora digital electrónica entre los años de

1937 a 1942. Llamó a su invento la computadora

Atanasoff-Berry, ó solo ABC (Atanasoff Berry

Computer). Un estudiante graduado, Clifford Berry, fue una

útil ayuda en la construcción de la computadora

ABC.

Sistemas de Tiempo Real

A menudo son utilizados como

dispositivos de control en aplicaciones dedicadas, como

control de experimentos científicos, sistemas de

procesamiento de imágenes médicas, sistemas de

control industrial, etc…Exige cumplimiento de restricciones de

tiempos.Sistemas de Tiempo Real

Críticos.

–

Cumplimiento forzoso de plazos de respuesta.

–

Predecibilidad y análisis de cumplimiento de plazos

de respuesta

Sistemas de tiempo real

acríticos.

– Exigencia

"suave" de plazos de respuesta.

–

Atención lo mas rápido posible a eventos, en

promedio.

UNIX

Los orígenes del sistema UNIX

se remontan al desarrollo de un proyecto iniciado en 1968. Este

proyecto fue realizado por General Electric, AT&T, Bell y el

MIT; llevaron a cabo el desarrollo de un sistema operativo con

nuevos conceptos como la multitarea, la gestión de

archivos o la interacción con el usuario. El resultado de

estas investigaciones se bautizó como MULTICS. El

proyecto resultó ser demasiado ambicioso, por lo que no

llegó a buen fin y terminó

abandonándose.

Posteriormente la idea de este proyecto se

vuelve a retomar y conduce al gran desarrollo en 1969 del sistema

operativo UNIX. Entre los investigadores destacaban Ken

Thompson y Dennis Ritchie. En principio, este sistema operativo

recibió el nombre de UNICS, aunque un año

después pasa a llamarse UNIX, como se conoce hoy en

día.

El código de UNIX estaba

inicialmente escrito en lenguaje ensamblador, pero en

1973, Dennis Ritchie llevó a cabo un proyecto para

reescribir el código de UNIX en lenguaje C. UNIX se

convirtió así en el primer sistema operativo

escrito en lenguaje de alto nivel. Con este nuevo enfoque fue

posible trasladar el sistema operativo a otras máquinas

sin muchos cambios, solamente efectuando una nueva

compilación en la máquina de destino. Gracias a

esto la popularidad de UNIX creció y permitió

asentar la "filosofía UNIX".

Inicialmente UNIX fue considerado como un

proyecto de investigación, hasta el punto de distribuirse

de forma gratuita en algunas universidades, pero después

la demanda del producto hizo que los laboratorios Bell iniciaran

su distribución oficial.

Después de tres décadas de

haber escapado de los laboratorios Bell, el UNIX sigue siendo uno

de los SO más potentes, versátiles y flexibles en

el mundo de la computación. Su popularidad se debe a

muchos factores incluidas su portabilidad y habilidad de correr

eficientemente en una inmensa variedad de computadoras. Descrito

frecuentemente como un sistema "simple, potente y elegante" el

UNIX es hoy el corazón que late en el seno de millones de

aplicaciones de telefonía fija y móvil, de millones

de servidores en universidades, centros académicos,

grandes, medianas y pequeñas empresas, el SO cuyo

desarrollo viene de la mano del de Internet y que alberga a

millones de servidores y aplicaciones de la red de redes. Sin

UNIX, no cabe duda, el mundo de la informática hubiera

sido otro.

Linux

En octubre de 1991 un estudiante

graduado de Ciencias de la Computación en la Universidad

de Helsinki, llamado Linus Torvalds, anuncia en Internet que

había escrito una versión libre de un sistema

MINIX (una variante de UNÍX) para una computadora

con procesador Intel 386 y lo dejaba disponible para todo aquel

que estuviera interesado. En los subsiguientes 30 meses se

desarrollarían hasta 90 versiones del nuevo SO,

finalizando en 1994 con la definitiva, llamándola Linux

versión 1.0.

La fascinación de los medios por

Linux viene dada, entre otras cosas, por ser un proyecto de

ingeniería de software distribuido a escala global,

esfuerzo mancomunado de más de 3 000 desarrolladores y un

sinnúmero de colaboradores distribuidos en más de

90 países. El rango de participantes en la

programación del Linux se ha estimado desde unos cuantos

cientos hasta más de 40.000, ya sea ofreciendo

código, sugiriendo mejoras, facilitando comentarios o

describiendo y enriqueciendo manuales. De hecho, se cuenta que el

mayor soporte técnico jamás diseñado de

manera espontánea y gratuita pertenece a este SO. Hoy

Linux es una alternativa para muchos o un indispensable para

otros. Su importancia no puede ser relegada: los RED HAT, los

SUSE, los Mandrake pueblan miles de servidores por todo el

planeta

Las Distribuciones de Linux

son:

Caldera: El énfasis de

esta distribución es la facilidad de uso e

instalación para los usuarios. Se orienta más

hacia el desktop a pesar que, como cualquier otra

distribución de Linux, puede ser usada para

servidores.Corel: Es una

distribución basada en Debian, pero extensivamente

modificada para hacerla tan fácil de usar como el

sistema operativo de Microsoft. Es quizá la

distribución más fácil de utilizar para

alguien que no esté familiarizado con Unix.Debian: Es una

distribución orientada más a desarrolladores y

programadores. El énfasis de esta distribución

es incluir en su sistema solamente software libre

según la definición de la Fundación del

Software Libre (FSF).Mandrake: Es una

distribución originalmente basada en RedHat que se

enfoca principalmente hacia la facilidad de uso. Al igual que

Corel, es recomendada para quienes no tengan mucha

experiencia con sistemas Unix.RedHat: Es la

distribución más popular de Linux y para la que

hay más paquetes comerciales de software. Está

orientada tanto al desktop como a servidores. La

mayoría de servidores de web que utilizan Linux como

sistema operativo usan esta distribución.S.U.S.E.: Es la

distribución más popular en Europa y

probablemente la segunda más popular del mundo. Al

igual que RedHat, está orientada tanto a desktops como

a servidores.Slackware: Es una

distribución de Linux que pretende parecerse a BSD

desde el punto de vista del administrador de sistemas. No es

una distribución muy popular a pesar que cuando

comenzó era la más popular.Stampede: Es una

distribución enfocada al rendimiento y velocidad del

sistema. No es muy fácil de usar para quién no

está acostumbrado a la administración de

sistemas Unix.

OS/2 (IBM

Operating System 2)

OS/2 son las siglas de "Sistema

operativo de segunda generación". La idea de OS/2

surgió entre IBM y Microsoft a mediados de los 80, en un

intento de hacer un sucesor de MS-DOS, el cual ya empezaba a

acusar el paso del tiempo y resultaba claramente desaprovechador

de los recursos de las máquinas de la época

(basadas en el Intel 286).

OS/2 1.0

OS/2 1.0 salió en abril de

1987 y era un sistema operativo de 16 bits, pues estaba pensado

para trabajar sobre el microprocesador 286. Sin embargo,

aprovechaba plenamente el modo protegido de este ordenador,

haciendo uso de sus capacidades para protección de

memoria, gestión de multitarea, etc. El resultado fue un

S.O. estable, rápido y muy potente.

OS/2 ya tenía incorporada desde esa

primera versión la multitarea real. Se podían

ejecutar varias sesiones simultáneamente, en cada una de

ellas se podían tener múltiples programas, y cada

uno de ellos podía tener múltiples threads en

ejecución. Se trataba de una multitarea jerárquica,

con cuatro niveles de prioridad: Crítico

(útil para programas que requieran atención casi

constante por parte del CPU, como un módem),

Primer plano (correspondiente al programa que tiene acceso

a la pantalla, teclado y ratón), Medio (programas

lanzados por el usuario que se ejecutan en BackGround) y

Desocupado (tareas de poca importancia o lentas, como el

Spooler de impresión). Dentro de cada nivel (a

excepción del de Primer plano), existen 32 niveles de

prioridad, los cuales son asignados dinámicamente a cada

programa por el S.O. en función del porcentaje de uso del

CPU, de los puertos de E/S, etc.

OS/2, además, permitía

memoria virtual, con lo que se podían ejecutar programas

más largos que lo que la memoria física instalada

permitiría en principio (los requerimientos de aquella

versión eran un 286 con 2 megas de memoria). Por otro

lado, incluía la característica de

compartición de código: al cargar dos veces

un mismo programa, el código de este no se duplicaba en

memoria, sino que el mismo código era ejecutado por dos

Threads diferentes. Esto permitía ahorrar mucha

memoria.

Esta versión de OS/2 era

íntegramente en modo texto. Si bien el Sistema Operativo

daba la posibilidad de usar los modos gráficos de la

tarjeta del ordenador, no incluía ningún API que

ayudase en ello, recayendo todo el trabajo de diseño de

rutinas de puntos, líneas, etc, en el programador de la

aplicación. Esto no era realmente tan problemático,

pues era lo que se hacía en el mundo del MS-DOS. Sin

embargo, se añoraba un entorno gráfico como

Windows.

OS/2 1.1

En la versión 1.1, aparecida

en octubre de 1988, llegó por fin el Presentation Manager,

un gestor de modo gráfico, junto con la primera

versión de Work Place Shell. Ambos formaban un entorno

gráfico muy parecido al aún no comercializado

Windows 3.0. También hizo su aparición el formato

de ficheros HPFS (High Performance File System). Este sistema de

ficheros complementaba al clásico FAT, que era el usado

por MS-DOS y por OS/2 1.0; sin embargo, ofrecía una gran

cantidad de ventajas, tales como:

Menor fragmentación de ficheros:

HPFS busca primero una zona en donde el archivo entre

completo, con lo que la fragmentación de ficheros es

prácticamente inexistente. De hecho, IBM recomienda

desfragmentar los discos duros una vez al año, y solo

a los paranoicos.Mayor capacidad: HPFS admite discos

duros de más capacidad, manteniendo el

tamaño del cluster (unidad mínima de

información almacenable) en 512 bytes o un sector. En

FAT, el tamaño mínimo de cluster para un disco

duro es 2048 bytes, y para discos mayores aumenta (un disco

duro de 1 giga tiene un tamaño de cluster de

32K).Soporte para nombres largos: Permite

nombres de hasta 256 caracteres.Mayor seguridad: Si al grabar en un

sector se detecta un error, se marca automáticamente

como defectuoso y se graba en otra parte.Mayor velocidad en el acceso: Gracias a

la estructura jerárquica de directorios, que optimiza

el acceso a disco.

El gran problema de OS/2 es que

seguía siendo un S.O. de 16 bits, con lo que no

aprovechaba plenamente las capacidades de los 386 de la

época, que empezaron a extenderse con más velocidad

de la esperada. Según una revista del sector, Microsoft

sugirió hacer una versión de 32 bits (que

obligaría a ejecutarla en ordenadores 386 o superiores),

pero IBM insistió en perfeccionar la de 16 bits. Sobre

quien dijo cada cosa realmente solo se puede especular. Lo

único que se sabe a ciencia cierta es que la

versión de OS/2 de 32 bits presentada por Microsoft en

1990 era casi igual que la versión 1.3, con la

única diferencia de que el kernel era de 32 bits. IBM, por

su parte, quería un escritorio orientado a objetos, y no

el clásico shell de OS/2 1.x (el cual Microsoft

copiaría para su Windows 3.0). Puestas así las

cosas, finalmente se rompió el acuerdo entre

ambos.

OS/2 2.0

Fué la primera

versión de OS/2 de 32 bits, iba a salir inicialmente a

finales de 1990; pero al no contar con la ayuda de Microsoft, IBM

no fue capaz de sacarlo hasta 1992, dándole a Windows 3.0

el tiempo suficiente para asentarse en el mercado.

OS/2 2.0 tenía todas las ventajas de

los anteriores OS/2, unido al nuevo núcleo de 32 bits. No

se trataba, por tanto, de un retoque de la versión de 16

bits, sino un sistema operativo prácticamente nuevo que

aprovechaba al máximo las capacidades del modo protegido

del microprocesador 386. Sin embargo, iba más allá

que Windows, pues al contrario que éste, ofrecía

compatibilidad garantizada con todas las aplicaciones de 16 bits

anteriores, gracias a la inclusión del API original de 16

bits junto con el nuevo de 32, y además sin perdida de

prestaciones. Así mismo, ofrecía también

compatibilidad con Windows 2.x y 3.0, junto con una

compatibilidad con MS-DOS muy mejorada, gracias al modo V86 que

incorporan los micros 386 y del que carecía el 286: en

OS/2 1.x la compatibilidad DOS era muy limitada, quedando

reducida a una sola tarea y realizando un cambio entre modo real

y modo protegido del microprocesador, además de consumir

de manera permanente 640 K de memoria. Aparte, la

emulación no era todo lo buena que cabía esperar.

Todos estos problemas desaparecieron en la versión 2.0,

pudiendo tener varias sesiones DOS totalmente independientes

entre sí, con una compatibilidad cercana al 100% y

beneficiándose de las capacidades de Crash Protection del

OS/2, que impiden que un programa pueda colapsar el sistema

entero.

Por otro lado, el Work Place Shell (el

shell de trabajo gráfico, de ahora en adelante WPS) fue

muy mejorado, resultando un shell totalmente orientado a objetos,

con acceso directo a los ficheros, carpetas dentro de carpetas,

ficheros sombra (conocidos como alias en los sistemas UNIX) y un

escritorio de verdad.

IBM consiguió vender OS/2 2.0 en

grandes cantidades; sin embargo, no consiguió su autentico

despegue, en parte por culpa de la falta de apoyo por parte de

las empresas del software. El API del Presentation Manager,

aunque similar al de Windows, tenía muchas diferencias,

con lo que las empresas tuvieron que elegir entre uno u otro,

ante la imposibilidad de muchas de ellas de dividir su talento

entre ambos sistemas.

OS/2 3.0

(Warp)

A principios de 1994 aparece el OS/2

Warp, nombre comercial de la versión 3.0 de OS/2. En ella

surgen nuevos elementos: un kit completo de multimedia (mejor del

que traía la versión 2.1) y el Bonus Pak, un kit de

aplicaciones que permite ponerse a trabajar con el ordenador nada

más instalar el Sistema Operativo, pues contiene elementos

como un Kit de conexión a Internet completo, el paquete

integrado IBM Works (formado por un procesador de textos, hoja de

cálculo, base de datos y gráficos de empresa, junto

con el PIM, que añade más funcionalidades

aprovechando las capacidades drag&drop del WPShell), soft de

terminal, soft de captura y tratamiento de video, etc. Así

mismo, la cantidad de hardware soportado fue ampliada de manera

considerable, soportando casi cualquier dispositivo existente en

el mercado: CD-Roms, impresoras, tarjetas de sonido, soporte

PCMCIA, tarjetas de video, tarjetas de captura de video, tarjetas

SCSI, etc. Los requisitos mínimos de esta versión

seguían siendo un 386SX a 16MHz con 4 megas de RAM, los

mismos que para Windows 3.11, y podía ejecutar programas

DOS, OS/2 16bits, OS/2 32 bits, Windows 2.x y Windows 3.x

(incluía además el API Win32, con lo que se

podían ejecutar incluso programas Windows de

32bits).

IBM se metió en una campaña

publicitaria a nivel mundial para promocionar esta nueva

versión, la cual, sin embargo, no dio los resultados

esperados. A pesar de eso, OS/2 es ampliamente utilizado en

múltiples empresas, bancos sobre todo, en donde su

estabilidad es la mayor garantía.

Poco después sale al mercado una

revisión de Warp, denominada Warp Connect, la cual

añade un kit completo de conexión a redes,

soportando prácticamente cualquier estándar de red,

incluyendo Novell Netware, TCP/IP, etc. junto con soporte para

SLIP y PPP.

OS/2 4.0

(Merlín)

En Noviembre de 1996 se hizo la

presentación de Merlín, nombre clave de OS/2

4.0, y que, en contra de lo que mucha gente piensa, no tiene nada

que ver con el mítico mago de la corte del rey Arturo,

sino con un pájaro parecido a un águila (siguiendo

la nueva filosofía de IBM de nombrar sus creaciones con

nombres de aves). Merlín trae todo lo que ofrecía

OS/2 3.0, pero lo amplía con un conjunto extra de

características, como son:

Un soporte todavía mayor de

hardware.Mayor simplicidad de

instalación.Librerías OpenDoc (compatibles

con OLE 2.0, pero más potentes).Librerías OpenGL, que permiten

aprovechar las capacidades 3D de las tarjetas que soporten

este estándar.API de desarrollo Open32, que permiten

recompilar con suma facilidad las aplicaciones escritas para

Windows95 y WindowsNT, de forma que aprovechen al

máximo los recursos de OS/2.Un Bonus Pack ampliado, incluyendo una

nueva versión del IBMWorks basada en OpenDoc, y las

utilidades LotusNotes.Un Kernel aún más

optimizado.Escritorio mejorado, ofreciendo una

orientación a objeto aún mayor.Un extenso soporte de conectividad,

superior a la versión Connect de Warp 3.0, lo que lo

convierte en el cliente de red universal, pudiendo conectarse

a casi cualquier servidor (no solo Warp Server, sino Windows

NT Server, Novell, etc).HPFS mejorado: mayor capacidad por

disco y seguridad.Sesiones DOS reales (el micro se

conmuta a modo real, y todo el contenido de la RAM se guarda

en disco, quedando el Sistema Operativo y el resto de las

utilidades congelados, pudiendo rearrancar en cualquier

momento. Es útil para juegos o programas de DOS muy

exigentes, que se niegan a funcionar en una sesión DOS

virtual).La Característica Estrella de

cara al Márketing: El VoiceType. Se trata de un

software reconocedor de voz, capaz de funcionar con cualquier

tarjeta de sonido, y que permite al usuario trabajar

exclusivamente mediante el dictado de comandos. Este sistema,

al contrario que otros disponibles hasta el momento,

realmente reconoce el habla de forma continua, de modo que no

sólo se puede usar para navegar por el escritorio y

controlar programas, sino que sirve perfectamente para dictar

cualquier tipo de texto, como artículos, cartas, etc.,

sin tocar una sola tecla. Se trata, por tanto, de un avance

de los que serán, sin duda, los sistemas operativos

del futuro.

Microsoft

Windows

De los tantos sistemas operativos que

se han hecho famosos a lo largo del desarrollo de la

informática en el ocaso del siglo pasado, sin duda,

ningún otro posee la peculiaridad del Windows de

Microsoft.Rodeado por todo tipo de mitos acerca de su emprendedor

y ambicioso creador, solidificado sobre la base de un sistema

DOS, cuya irrupción en la primera PC tenía

más de suerte que de propósito, amparado por

disfrutar de un férreo y despiadado control de mercado es

hoy por hoy, odiado o amado, el sistema operativo más

extendido del planeta.

MS-DOS

Cuando IBM fabricó la PC hizo

que el usuario antes de cargar algún SO, realizara lo que

se llamó el POST (Power On Self Test), que

determinaba los dispositivos disponibles (teclado, vídeo,

discos, etc.) y luego buscaba un disco de arranque. Estas

funciones eran realizadas por un conjunto de instrucciones

incorporad.as en la máquina mediante una ROM Luego

quedó escrito que siempre hubiera algún tipo de

software en el sistema aún sin ser cargado el SO. Entre

las rutinas del POST tenemos las de revisión del sistema,

inicialización y prueba de teclado, habilitación de

vídeo, chequeo de la memoria y la rutina de

inicialización que preparaba a la máquina para

ejecutar el DOS. Después que las pruebas de arranque han

sido ejecutadas y el sistema está cargado, la ROM

aún sigue siendo importante debido a que contiene el

soporte básico de entrada y salida (BIOS). La BIOS

provee un conjunto de rutinas que el SO o los programas de

aplicación pueden llamar para manipular el monitor,

teclado, discos duros, discos flexibles, puertos COM o

impresoras.

El trato de IBM con Microsoft tenía

entre otras condiciones una particularidad interesante: la

administración directa de las tarjetas adaptadoras

podría ser manejada sólo por programas que IBM

proveía con la ROM del computador. El DOS sería

escrito para utilizar estos servicios. De esta manera, si IBM

decidía cambiar el hardware, éste podía

embarcar nuevos modelos de chips con cambios en la BIOS y no

requería que Microsoft cambiara el SO. Ello

posibilitó, junto con la clonación de la

arquitectura de IBM incluido la BIOS, que el DOS se extendiera

por el universo, aun cuando el Gigante Azul rompiera su alianza

con Microsoft, en 1991, para producir su propio SO. Microsoft

había hecho un trabajo estratégico brillante e IBM

había perdido la supremacía de las computadoras

para siempre.

Realmente el núcleo del DOS estaba

contenido en un par de archivos ocultos llamados IO.SYS y

MSDOS.SYS en las versiones de DOS realizadas por

Microsoft, e IBMBIO.SYS, para las versiones de DOS hechas por IBM

bajo licencia Microsoft. Los servicios del DOS eran solicitados

cuando una aplicación llamaba a la interrupción 21

(INT 21) reservada para estos fines. Esta buscaba un punto de

entrada del administrador de servicios del DOS en una tabla y

saltaba a la rutina en el módulo MSDOS.SYS. En otros SO,

la aplicación debía realizar una llamada al sistema

(system call) para requerir servicios, como, por ejemplo, en

UNIX.

Otro rasgo distintivo del MS-DOS fue la

forma en el manejo de la estructura de ficheros: la FAT

(File Allocation Table) o Tabla de Asignación de Archivos,

que dividía al disco en subdirectorios y archivos.

Criticados por muchos como un sistema poco seguro y no eficiente,

la herencia sobrevivió por mucho tiempo y no fue hasta

época reciente que Microsoft decidió reemplazarlo

por un sistema más robusto, el NTFS que destinó a

la gama alta de sus SO: el Windows NT, 2000 y XP.

Windows 1.0

Microsoft hizo su primera

incursión en lo que luego se llamaría Microsoft

Windows en el año 1981 con el llamado Interface Manager,

en tiempos en que las interfaces gráficas de usuario, GUI,

eran una quimera de lujo para muchos, en tanto la

computación estaba suscripta al área

geográfica de los centros académicos, grandes

instituciones y empresas. Más que un SO, se trataba en

realidad de una interfaz montada sobre su estrenado DOS. Aunque

los primeros prototipos usaban una interfaz similar a una de las

aplicaciones estrellas de la Compañía en aquel

entonces, el Multiplan, luego ésta fue cambiada por

menús pulldown y cuadros de diálogo, similares a

las usadas en el programa Xerox Star del mencionado fabricante.

Al sentir la presión de programas similares en aquel

entonces, Microsoft anuncia oficialmente Windows a finales del

año 1983. En ese momento, muchas compañías

trabajan la línea de las interfaces gráficas, entre

ellas Apple, reconocida casi por todos como la primera, DESQ de

Quraterdeck, Amiga Workbech, NEXTstep, etc. Windows

prometía una interfaz GUI de fácil uso, soporte

multitarea y gráfico. Siguiendo el rito de los

anuncio-aplazamientos de Microsoft, Windows 1.0 no llegó a

los estantes de los negocios hasta noviembre de 1985, disponiendo

de un soporte de aplicaciones pobres y un nivel de ventas

pírrico. El paquete inicial de Windows 1.0 incluía:

MS-DOS Ejecutivo, Calendario, Tarjetero, el Notepad, Terminal,

Calculadora, Reloj, Panel de Control, el editor PIF (Program

Information File), un Spooler de impresión, el Clipboard,

así como el Windows Write y Windows Paint.

Windows 2.0

Windows/286 y Windows/386,

renombrados como Windows 2.0 terminan la saga en el otoño

de 1987, al ofrecer algunas mejoras de uso, adicionar

íconos y permitir la superposición de ventanas, lo

que propició un marco mucho más apropiado para la

con-ubicación de aplicaciones de mayor nivel como el

Excel, Word, Corel Draw, Ami y PageMaker, etc. Una notoriedad del

Windows/386 lo constituyó el hecho de poder correr

aplicaciones en modo extendido y múltiples programas DOS

de manera simultánea.

Windows 3.0

El Windows 3.0, que aparece en mayo

de 1990, constituyó un cambio radical del ambiente Windows

hasta entonces. Su habilidad de direccionar espacios de memorias

por encima de los 640 k y una interfaz de usuario mucho

más potente propiciaron que los productores se estimularan

con la producción de aplicaciones para el nuevo programa.

Ello, unido a la fortaleza dominante del MS-DOS como SO llevado

de la mano de la gula insaciable del gigante corporativo, hizo

que el Windows 3.0 se vislumbrara como el primer SO

gráfico (siempre con el MS-DOS bajo su estructura)

marcado para dominar el mercado de las PCs en el futuro

inmediato. Windows 3.0 fue un buen producto, desde el punto de

vista de las ventas: diez millones de copias.

Windows 3.1 y 3.11

En 1992 llegaría la saga

del Windows 3.1 y 3.11, así como su variante para trabajo

en grupo. Con éste se hizo patente el traslado de la

mayoría de los usuarios del ambiente de texto que

ofrecía el MS-DOS hacia el ambiente gráfico de la

nueva propuesta, olvidándonos todos paulatinamente del

Copy A: *.* para sustituirlo por el COPIAR Y PEGAR. Las primeras

aplicaciones "adquiridas y/o desplazadas" por Microsoft ofrecidas

como un todo único, el ambiente de RED peer to peer, los

sistemas de upgrade de una versión a otra y el tratamiento

diferenciado para los revendedores y los fabricantes OEM,

caracterizaron los movimientos de Microsoft para afianzar el

mercado de su SO insignia. En el caso de la versión para

trabajo en grupo, Microsoft integró por primera vez su SO

con un paquete de tratamiento para redes, lo que permitió,

sobre un protocolo propio, el compartir ficheros entre PCs

(incluso corriendo DOS), compartir impresoras, sistema de correo

electrónico y un planificador para trabajo en grupo. Sin

embargo, lo realmente llamativo consistió en su plena

integración con el ambiente Windows y con ello garantizar,

independiente de la calidad del producto final, un seguro

predominio.

Windows 95

El año 1995 significó

un nuevo vuelco en la línea de los SO de Microsoft. En

agosto sale al mercado el controvertido Windows 95, un entorno

multitarea con interfaz simplificada y con otras funciones

mejoradas.

Parte del código de Windows 95

está implementado en 16 bits y parte en 32 bits. Uno de

los motivos por los cuales se ha hecho así, ha sido para

conservar su compatibilidad. Con Windows 95 podemos ejecutar

aplicaciones de Windows 3.1 ó 3.11, MS-DOS y obviamente

las nuevas aplicaciones diseñadas específicamente

para este sistema operativo. Entre las novedades que ofrece

Windows 95 cabe destacar el sistema de ficheros de 32 bits,

gracias al cual podemos emplear nombres de ficheros de hasta 256

caracteres (VFAT y CDFS), debido a que se trata de un sistema

operativo de modo protegido, desaparece la barrera de los 640K,

hemos de tener presente que aunque la mayor parte de Windows 3.1

es un sistema de modo protegido, este se está ejecutando

sobre un sistema operativo que trabaja en modo real.

La interfaz de Windows 95 también ha

sido mejorada. El primer gran cambio que veremos al empezar a

trabajar será la desaparición del Administrador de

Programas. Ahora tenemos un escritorio al estilo del Sistema 7 de

los Macintosh o NeXTStep.

Viene a sustituir al sistema operativo DOS

y a su predecesor Windows 3.1. Frente al DOS tiene tres ventajas

importantes:

En primer lugar toda la

información presentada al usuario es gráfica,

mientras que el DOS trabaja con comandos en modo texto

formados por órdenes difíciles de

recordar.En segundo lugar, Windows 95 define una

forma homogénea de utilizar los recursos de la

computadora, lo cual permite compartir datos entre las

distintas aplicaciones, así como utilizar con

facilidad los elementos de hardware ya instalados.En tercer lugar Windows 95 es un

sistema operativo que permite ejecutar varias aplicaciones a

la vez (multitarea), mientras que en DOS sólo se puede

ejecutar un programa en cada momento.

A sólo siete semanas de su

lanzamiento ya se habían vendido siete millones de copias.

Es la época del despegue de Internet y el WWW, y su

visualizador dominante: el Navigator de Netscape. Microsoft, en

un error poco común de su timonel no se había dado

cuenta que el futuro de las computadoras estaba precisamente en

la red y que Internet significaría toda una

revolución en la rama.

Además de "empotrar" su navegador y

obligar a los fabricantes de PCs a tenerlo en cuenta, ese mismo

año se crea The Microsoft Network y mediante su

incursión acelerada en los medios masivos de

comunicación, surge MSNBC, un año

después.

Windows NT

La misión del equipo de

desarrolladores que trabajó el NT estaba bien definida:

construir un SO que supliera las necesidades de este tipo de

programa para cualquier plataforma presente o futura. Con esa

idea, el equipo encabezado por un antiguo programador de SO para

máquinas grandes, se trazó los siguientes

objetivos: portabilidad en otras arquitecturas de 32 bits,

escalabilidad y multiprocesamiento, procesamiento distribuido,

soporte API y disponer de mecanismos de seguridad clase 2

(C2), según parámetros definidos por el

Gobierno estadounidense.La robustez del sistema, fue un requisito

a toda costa: el NT debía protegerse a sí mismo de

cualquier mal funcionamiento interno o daño externo,

accidental o deliberado, respondiendo de manera activa a los

errores de hardware o software. Debía ser desarrollado

orientado al futuro, prever las necesidades de desarrollo de los

fabricantes de equipos de cómputo, su adaptación

tecnológica no sólo al hardware, sino al propio

software. Todo ello sin sacrificar el desempeño y

eficiencia del sistema. En cuanto al certificado de seguridad, C2

debiera cumplir con los estándares establecidos por

éste como la auditoría, la detección de

acceso, protección de recursos, etc. Así

nació el Windows NT 3.5, devenido 3.51 en el año

1994 y se introdujo poco a poco en un mercado hasta ese momento

desterrado para Microsoft.

El NT 4.0 de nombre código

Cairo, sale a luz en 1996. Por ahí leíamos

que el nuevo sistema operativo cumplía una fórmula

muy sencilla: tomar un NT 3.51, sumarle los service packs 1, 2 y

3 y mezclarlo con una interfaz a lo Windows 95 (incluido su

papelera de reciclaje, algo realmente útil para un sistema

montado sobre NTFS). Un paso más en la integración

del SO con Internet lo dio el NT 4.0 al incluir Internet

Information Server, servidor de Microsoft para soporte WEB, FTP,

etc., como un utilitario más dentro del paquete y que como

la lógica indicaba engranaba con éste a las mil

maravillas al desplazar en eficiencia y velocidad cualquier

producto externo. La cara "Windows 95" se sobrepuso a un inicio

incierto, ya que tuvo que vencer la desconfianza que pudo haber

generado. Téngase en cuenta, que la familia NT estaba

orientada a un cliente en el que la estabilidad y seguridad del

sistema eran el requisito número uno y ello contrastaba

con la experiencia que había tenido el 95. Sin embargo, el

golpe fue genial. Por primera vez, Microsoft mezcló la

solidez con el fácil uso y desterró para siempre el

concepto impuesto hasta entonces de que para las grandes

compañías y las grandes empresas los servidores

debían ser cosa de científicos de bata blanca. El

crecimiento de los usuarios NT se multiplicó desde ese

momento. EL 4.0 se comercializaba en tres versiones:

Workstation, Server y Advanced Server para

tres variantes de clientes tipo, el profesional de las

ingenierías, incluido la informática, la

pequeña y mediana empresas y la gran empresa.

Windows 98

La llegada de Windows 98 no

marcó mucha diferencia visual de su predecesor. Sin

embargo, en el fondo fue todo un mensaje de lo que Microsoft

haría para penetrar en el mercado de Internet y barrer con

los que habían dominado en este tema hasta entonces. La

indisoluble integración del WEB con el escritorio, el

llamado active desktop, la interfaz "HTML", los

canales y la persistente presencia del Explorer 4.0, para

situarse por vez primera a la cabeza de los visualizadores de

Internet, fueron rasgos distintivos de esta versión. El 98

incluyó utilidades para el tratamiento de FAT16 y su

conversión a FAT32, mejor manejo de los discos duros,

manipulación múltiple de varios monitores, una

lista extendida de soporte plug and play, soporte DVD, AGP, etc.

A su vez la promesa de una mejora sustancial en el tratamiento de

los drivers de dispositivos y en la disminución de los

pantallazos azules, que realmente cumplió y mejoró

con la versión SR1 (service release 1), tiempo

después.

Las nuevas características de

Windows 98 ofrecen sacar mucho más partido del PC. Los

programas se ejecutan más rápido, pudiendo ganar

una promedio de un 25% o más de espacio en el disco,

Internet pasa a ser una parte muy importante en el ordenador,

dando un paso gigante en la entrega de contenido multimedia de

alta calidad.

El Windows 98 se ha mantenido hasta

nuestros días y debe ser la última versión

del SO que quede vinculada a lo que fue la línea

MS-DOS-Windows (salvando la variante Millenium o Windows Me que

no ha convencido a nadie) hasta su total sustitución por

Windows 2000 y el XP, en una serie de zigzagueantes cambios que

deja a todos adivinando si debe cambiar o no para la

próxima versión. Pero tras este errático

rumbo, Microsoft persigue sólo una cosa: conservar la

supremacía de los SO de por vida.

Windows Millenium

El 14 de septiembre sale el Windows

Millenium, no como un sucesor del 98, sino como un producto

orientado al usuario doméstico (interfaz de colores, mucha

música y vídeo, soporte para redes LAN

inalámbricas, cortafuegos personales), nada del otro

mundo, con poca perspectiva de supervivencia.

Windows 2000

Se ofrece en 4 clasificaciones:

Windows 2000 Professional, Windows 2000 Server

(anteriormente NT Server), Windows 2000 Advanced Server

(anteriormente NT Advanced Server) y Windows 2000 Datacenter

Server, un producto nuevo, poderoso y muy específico

con posibilidad de manejo de hasta 16 procesadores

simétricos y 64 Gb de memoria física.

Lo destacable de este paso estriba en haber

llevado la robustez, la seguridad y la portabilidad que daba el

NT al mercado masivo de las PCs. Este ofrece una plataforma

impresionante para el trabajo en Internet, Intranet, manejo de

aplicaciones, todo muy bien integrado. La posibilidad de soporte

completo de redes, incluido redes privadas virtuales,

encriptación a nivel de disco o de red y riguroso control

de acceso son otras de sus bondades.

Windows XP (

Experience)

Desde que apareció Windows95

las sucesivas versiones han sido una evolución de la

original, sin embargo en esta ocasión se ha producido un

cambio de mayor envergadura ya que se ha cambiado el

núcleo o Kernel del sistema operativo.

Aunque de cara al usuario no se noten

cambios radicales, se puede decir que Windows XP no es solo una

versión más de Windows sino que supone

prácticamente un nuevo sistema.

Hasta ahora Microsoft disponía de

dos sistemas operativos diferentes, para el entorno personal o

doméstico tenía Windows98 y para el entorno

profesional (o de negocios) el Windows NT/2000.

Con Windows XP se produce una convergencia

entre ambas versiones ya que se ha partido del núcleo del

sistema de Windows 2000 para crear Windows XP y a partir de

ahí se han realizado algunos retoques para diferenciar dos

versiones de Windows XP, una para el ámbito personal

llamada Windows XP Home Edition, y otra para el ámbito

profesional denominada Windows XP Professional.

El principal beneficio de esta estrategia

para los usuarios domésticos va a ser que Windows XP ha

adquirido la robustez y estabilidad de Windows NT/2000, esto debe

suponer que Windows XP se quedará menos veces bloqueado,

habrá menos ocasiones en la que tengamos que reiniciar el

sistema como consecuencia de un error.La mejora para los usuarios

profesionales se debe a que Windows XP tiene mayor compatibilidad

con el hardware de la que gozaba Windows NT/2000.

Windows XP dispone de un nuevo sistema de

usuarios completamente diferente respecto a Windows98. Este nuevo

sistema ha sido heredado de Windows NT/2000.

Ahora se pueden definir varios usuarios con

perfiles independientes. Esto quiere decir que cada usuario puede

tener permisos diferentes que le permitirán realizar unas

determinadas tareas. Cada usuario tendrá una carpeta Mis

documentos propia que podrá estar protegida por

contraseña, un menú de inicio diferente.

También se dispone de una carpeta a la que tienen acceso

todos los usuarios y donde se pueden colocar los documentos que

se quieren compartir con los demás usuarios.

Para pasar de un usuario a otro no es

necesario apagar el ordenador, ni siquiera que un usuario cierre

lo que estaba haciendo, simplemente hay que iniciar una nueva

sesión con otro usuario, más tarde podremos volver

a la sesión del primer usuario que permanecerá en

el mismo estado que la dejó. El sistema se encarga de

manejar a los distintos usuarios activos y sin

interferencias.

El Desarrollo de los Lenguajes y

Técnicas de Programación

Paralelo al desarrollo de la ciencia de la

computación y de las máquinas correspondientes fue

tomando auge la técnica relativa a los métodos de

suministrar las instrucciones a las máquinas con vistas a

realizar un determinado trabajo de cálculo. Fueron dos

mujeres las grandes pioneras de las técnicas e idiomas de

programación, independientemente del aporte que los

hombres también brindaron.

Se reconoce generalmente como la primera

gran pionera en este campo a Lady Ada Augusta Lovelace,

única hija legitima del poeta ingles Lord Byron, nacida en

1815.

Entre los muchos aportes que hizo a la

ciencia de la computación Lady Lovelace, mientras

estudiaba la máquina de Babbage, el más

sobresaliente probablemente fue el que estaba relacionado con el

concepto de lo que hoy llamamos 'lazos' o

'subrutinas'

Lady Lovelace planteó que en una

larga serie de instrucciones debía haber necesariamente

varias repeticiones de una misma secuencia. Y que

consecuentemente debía ser posible establecer un solo

grupo de tarjetas perforadas para este grupo de instrucciones

recurrentes. Sobre este mismo principio trabajaron posteriormente

los conocidos matemáticos ingleses Alan Turing y John Von

Neumann.

En 1989 el único lenguaje aceptado

por el Departamento de Defensa Norteamericano es el llamado

ADA, este en honor de la Condesa ADA Lovelace. ADA

surgió por la necesidad de unificar los más de 400

lenguajes y dialectos que dicho departamento utilizaba en sus

proyectos, de forma que el tiempo y dinero invertidos en el

desarrollo de software para uno de ellos fuera utilizable en otro

de similares características.

Casos legales de

Microsoft

Dominación de mercado y libre

competencia en la nueva economía de la Sociedad de la

Información

Aunque las firmas dominantes en el sector

de las TI no se asemejan a los monopolios tradicionales que han

podido surgir a lo largo de la historia en otros sectores de la

economía, sin embargo el buen funcionamiento de los

mercados exige su sumisión a las leyes de defensa de la

competencia. El juicio que desde el 19 de Octubre enfrenta a

Microsoft con las autoridades antitrust de los Estados Unidos no

es un caso aislado y de naturaleza particular, sino que sus

consecuencias tendrán un impacto indudable sobre las bases

económicas y jurídicas en las que se asienta el

funcionamiento de los mercados de tecnologías de la

información.

Los razonamientos tradicionales del

análisis microeconómico clásico a favor del

ideal de la libre competencia y en contra de las imperfecciones

del mercado, son bastante conocidos. Sin embargo lo que abunda en

la práctica, en el funcionamiento real de la

mayoría de los sectores económicos, son

precisamente las imperfecciones. Los mercados son instituciones

que reúnen a productores y consumidores, y ya Alfred

Marshall (1), el gran economista de la Universidad de Cambridge,

explicó cómo su estructura determina en gran medida

la manera en que actúan las fuerzas encargadas de resolver

la pugna del reparto del valor económico creado, es decir

qué parte del mismo irá al consumidor (utilidad) y

cuál al productor (beneficio).